CS 공부/AI

Neural network

imsmile2000

2023. 1. 9. 21:29

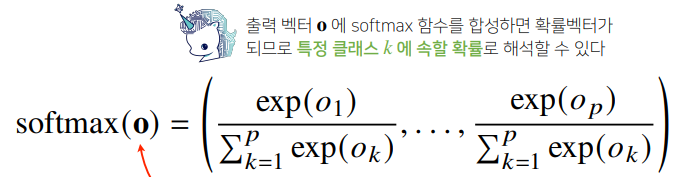

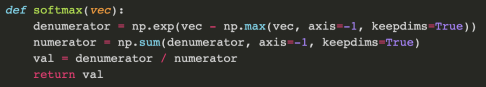

- softmax 연산: 모델의 출력을 확률로 해석할 수 있게 변환해주는 연산

- 분류 문제를 풀 때 선형모델과 소프트맥스 함수를 결합하여 에측

- softmax 함수를 통해 R^p에 있는 벡터를 확률벡터로 변환

- 그러나 추론을 할 때는 one-hot 벡터로 최대값을 가진 주소만 1로 출력하는 연산을 사용 (softmax는 학습에 사용)

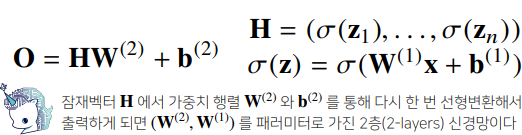

- 신경망: 선형모델과 활성함수를 합성한 함수

- 활성함수: 비선형 함수 ( sigmoid, tanh, ReLU), ReLU가 딥러닝에 제일 많이 쓰임

- 층을 여러개 쌓는 이유: 더 적은 노드의 개수로 목적함수를 근사할 수 있어 효율적 학습이 가능

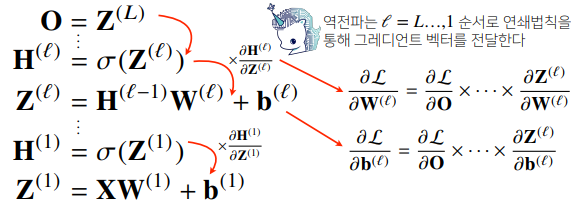

- 역전파 알고리즘: 합성함수의 미분법인 연쇄법칙 기반 자동 미분을 사용

ex) z=(x+y)^2 , w=x+y